CPU、GPU、NPU、FPGA:AI时代的“推手”到底谁更强?

在计算机的世界里,有四位 “算力能手” 各有所长,它们不仅支撑着我们日常的电脑使用,更在人工智能浪潮中扮演着关键角色。今天就用大白话聊聊 CPU、GPU、NPU、FPGA 这四位 “高手” 的区别、未来发展,以及它们在 AI 领域的潜力。

一、四位 “能手” 各有绝活:区别一眼看穿

CPU:万能 “总管”

就像办公室里的全能主管,啥活都能扛。擅长处理复杂逻辑(比如判断 “如果… 就…”)和一步接一步的串行任务,电脑的操作系统、办公软件、浏览器都由它调度。是整个系统的 “大脑”。

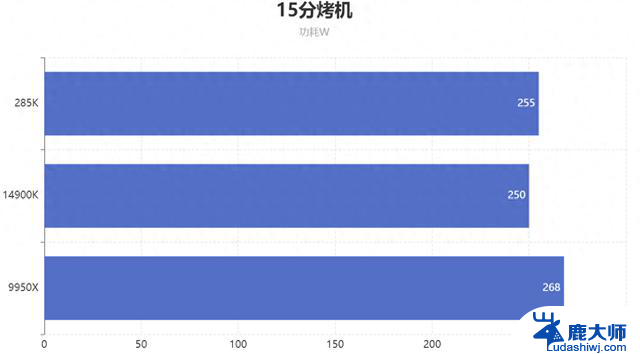

GPU:并行 “猛将”

带了一群 “小弟”(大量并行计算单元),最擅长干重复、密集的体力活,比如处理图片里的每一个像素。原本是给游戏、3D 建模做图形渲染的,后来发现搞深度学习训练、科学计算也很在行,毕竟这些任务需要同时算一堆数据。

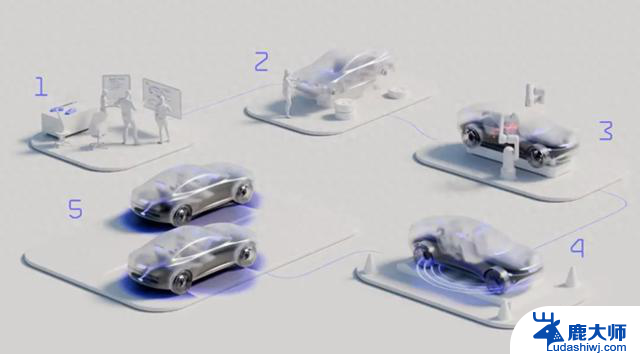

NPU:AI “专才”

天生为人工智能而生,专门优化神经网络里的 “矩阵乘法”“卷积操作” 这些 AI 常用计算,效率高还省电。手机拍照的 AI 美颜、语音助手识别、自动驾驶 “看” 路况,靠的就是它,轻量级的 AI 模型训练也能搞定。

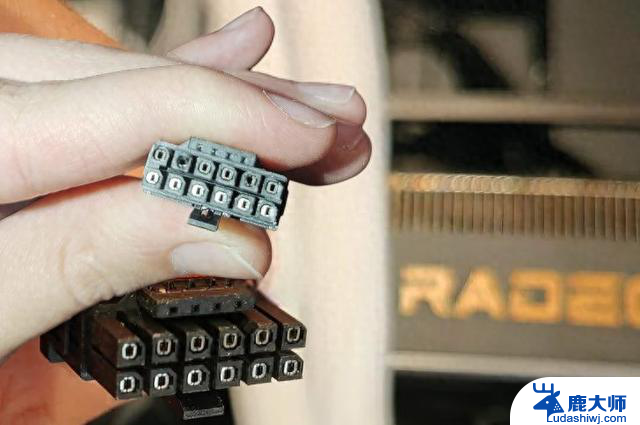

FPGA:可定制 “工具人”

硬件结构能像搭积木一样重新编程,既灵活又能达到专用硬件的效率,但编程稍微复杂点。适合需要量身定制加速的场景,比如处理特殊的通信协议、视频编解码,研发新算法时用它快速测试也很方便。

二、未来趋势:它们会怎么 “升级”?

CPU:走 “全能 + 节能” 路线

不再比拼单个核心的速度,而是靠 “多核团队” 发力,再加上 AI 加速功能(以后电脑里带 AI 加速器会成标配)。工艺越来越先进(3nm、2nm 都安排上),还会用 Chiplet 技术把不同功能模块拼起来,既省钱又灵活,同时更省电。

GPU:更强、更融合

计算能力、图形渲染能力会越来越强,能耗却更低。还会和 CPU、FPGA 这些 “同事” 合作更紧密,组成高效的 “混合团队”(异构计算架构),满足不同领域的需求。

NPU:变得更 “聪明”

从固定功能的 “流水线” 变成能灵活适应不同任务的平台,比如能处理动态变化的深度学习工作。会嵌入更多 AI 加速器,还能帮着检测异常和威胁,在 5G、物联网设备上的 AI 推理会更优化。

FPGA:应用场景更宽

在 AI 领域会更给力,比如加速 AI 算法运行;通信网络里能快进数据包处理;机器视觉(人脸识别、目标跟踪)、自动驾驶决策这些场景也少不了它。随着技术进步,用起来会更方便,会有更多开发者选择它。

三、AI 领域前景:谁能 C 位出道?

CPU:稳扎稳打型

能跑大语言模型推理,比如英特尔的处理器就内置了 AI 加速器。如果对算力要求不高,但看重系统稳定、数据安全和成本,比如医疗病历智能总结、法律案例整理,选它性价比高。而且它作为通用资源,容易获取和维护,还能复用现有设备的空闲算力。

GPU:核心主力型

靠超强的并行计算能力,在深度学习的训练和推理中必不可少,矩阵运算、卷积操作这些 AI 核心任务干得又快又好。未来会更广泛应用在自动驾驶、图像 / 语音识别这些对实时性要求高的场景,还会和其他技术结合,助力医疗、金融、工业等领域的 AI 发展。

NPU:AI 专属型

高效、省电、定制化的特点,让它在图像识别、语音识别、自然语言处理这些领域优势明显。以后性能会更强,还可能支持模型压缩等功能,智能手机、智能摄像头、自动驾驶汽车里都会有它的身影。

FPGA:灵活应变型

特别适合对实时性、低延迟要求极高的场景,比如自动驾驶中融合传感器数据并快速决策。它能根据 AI 算法需求定制硬件,灵活适应算法更新。在机器视觉、数据中心 AI 加速、边缘设备数据处理等领域都有大前景,未来会被更多 AI 开发者青睐。

这四位 “算力能手” 各有侧重,却又相互配合,共同推动着计算机技术和人工智能的发展。不管是日常办公还是 AI 黑科技,背后都有它们的身影,未来值得期待!